Nach einem kritischen Gespräch mit tragischem Ende verklagen zwei Eltern OpenAI, die Firma hinter ChatGPT. Der CEO zieht nun die Konsequenzen und will seine KI „sicherer“machen – mit potentiellen Auswirkungen für alle Nutzer.

Um welche Themen geht es?

Aktuell könnt ihr mit künstlichen Intelligenzen wie ChatGPT über fast alle Themen sprechen.

In einem Fall in den USA soll es inzwischen vorgekommen sein, dass ein Chatbot einen Teenager dazu ermutigt haben soll, sich das Leben zu nehmen – inklusive Anleitung.

Eine andere KI soll mit Minderjährigen geflirtet haben und sie anschließend zum Suizid angestiftet haben. Beide Fälle führten zu einer Klage gegen das jeweilige Unternehmen.

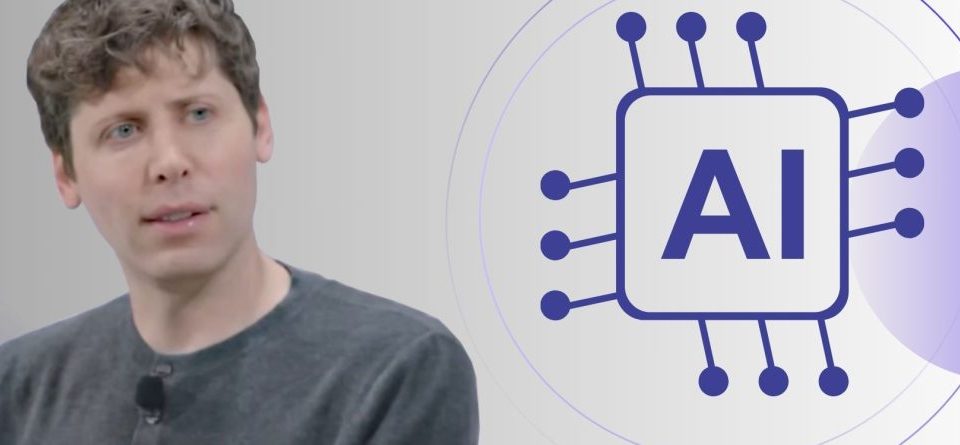

Das will ChatGPT ändern: Sam Altman, der CEO von OpenAI, schreibt in einem Blogpost, dass man die Themen Sicherheit für Teenager, Freiheit und Datenschutz angehen wolle. Zunehmend mehr Menschen würden immer sensiblere Themen mit künstlichen Intelligenzen besprechen.

Datenschutz müsse entsprechend verbessert werden, ähnlich wie wenn man seine Gebrechen mit einem Arzt bespreche oder rechtliche Probleme mit einem Anwalt. Dazu gebe es neue Sicherheits-Features. Insbesondere beim Schutz von Jugendlichen wolle man aber nachlegen. Konkret heißt es:

Wir priorisieren Sicherheit über Datenschutz und Freiheit für Teenager; das [KI] ist eine neue und mächtige Technologie und wir glauben, Minderjährige benötigen erheblichen Schutz.

Sam Altman, CEO von OpenAI

Themen wie Suizid sollen demnach nicht mehr mit Minderjährigen besprochen werden. Im Ernstfall wolle man sogar direkt die Eltern oder entsprechende Behörden informieren, wenn eine unmittelbare Gefahr zu befürchten sei.

Weitere Hilfsangebote findet ihr auf der Homepage der Deutschen Gesellschaft für Suizidprävention.

Datenschutz und Sicherheit sind immer eine schwierige Sache bei KI:

Autoplay

Im Zweifel bekommen alle die Variante für Jugendliche

Erwachsene sollen weiterhin sämtliche Freiheiten genießen. Altman schreibt: Wenn ein Autor etwa Hilfe dabei haben wolle, für sein Buch über Suizid zu schreiben, solle das weiter möglich sein. Auch der Wunsch, dass die KI mehr flirte, solle erfüllbar bleiben.

Lediglich Jugendliche sollen vor so etwas geschützt werden. In einem weiteren Blogpost wird erklärt, wie die Erkennung funktionieren soll. Zuallererst sollen Eltern die Möglichkeit haben, über eine Eltern-Kontrolle einzustellen, wie sich die KI verhalten soll.

Minderjährige Nutzer werden dann zu einem „ChatGPT mit altersgemäßen Richtlinien“ geleitet. Des Weiteren wolle man eine Erkennung einbauen: Anhalt des Nutzer-Verhaltens soll die KI bestimmen, ob ein erwachsener oder ein minderjähriger Nutzer chattet.

Im Zweifel solle immer die sichere, also die Variante für Jugendliche gewählt werden – und, wenn es nicht anders geht und mit den lokalen Gesetzen vereinbar ist, wolle man einen Ausweis verlangen, um das Alter zu verifizieren: „Wir wissen, dass das dem Datenschutz für Erwachsene entgegenläuft, aber wir glauben, dass der Kompromiss das wert ist.“

Eine solche Alterskontrolle gibt es schon an anderen Stellen im Internet und sogar im Gaming. Einen tiefen Einschnitt in den Datenschutz hat das vereinigte Königreich per Gesetz verabschiedet: In Großbritannien müssen Spieler jetzt ihr Alter auf Steam beweisen und das zeigt, was bald auf deutsche Spieler zukommen könnte

Der Beitrag ChatGPT weigert sich bald, brisante Themen mit der Gen Alpha zu besprechen, verlangt unter Umständen einen Ausweis erschien zuerst auf Mein-MMO.